Un retour sur la “loi de Moore” permet de mesurer l’ampleur du bouleversement d’innovations numériques en cours et à venir.

Par Georges Lane.

Au cœur de l’activité économique, il y a le progrès technique que génère l’homme. Pour cette raison, le diagramme qui suit (figure 1) mérite attention.

Il fait apparaître une hausse considérable de la miniaturisation des transistors dans les ordinateurs, qui atteignaient un point de l’ordre de 2600 millions en 2011. Il vise aussi à s’interroger sur l’avenir de la “loi de Moore” qui, en particulier, a contribué à faire passer les gens du monde de l’ère de Gutenberg à celui de l’ère numérique.

La miniaturisation

Il y a treize ans, la “loi de Moore” amenait au diagramme ci-dessous (figure 2) :

Soit dit en passant, pour une visite du musée de l’innovation de Intel, voir ici.

Entre 2000 et 2011, en dix ans, le nombre de transistors de référence est donc passé de 100 millions à 2600 millions après être passé, de 1971 à 2000, en trente ans, de 2300 à 100 millions. Les 10 millions de 1998 qui ont contribué à faire connaître Internet au public dans le monde sont dérisoires comparé au chiffre donné, 2600 millions ! La hausse rapide de ces dernières années qui a fait passer de 1000 millions à 2600 est tout autant considérable. Ces variations de mesure sont colossales ainsi que leur progression.

Faut-il enfoncer le clou et insister sur le fait que la variation dans laquelle on se trouve aujourd’hui est sans commune mesure avec celles qui ont existé antérieurement ? Les plus folles réalisations sont à venir.

La défaillance économique

Malgré cela, malgré ce progrès technique jusqu’à présent a priori sans limites, des économistes font valoir qu’il n’y a pas eu d’innovation fondamentale, que le phénomène ne présente pas outre mesure d’intérêt économique. Oublions les.

Ou alors ils mettent l’accent sur un des résultats, à savoir les données que l’innovation a permises (cf. par exemple en matière d’open source) comme si ces données étaient autant de contraintes.

Limite physique et limite économique font deux

Limite physique et limite économique font deux

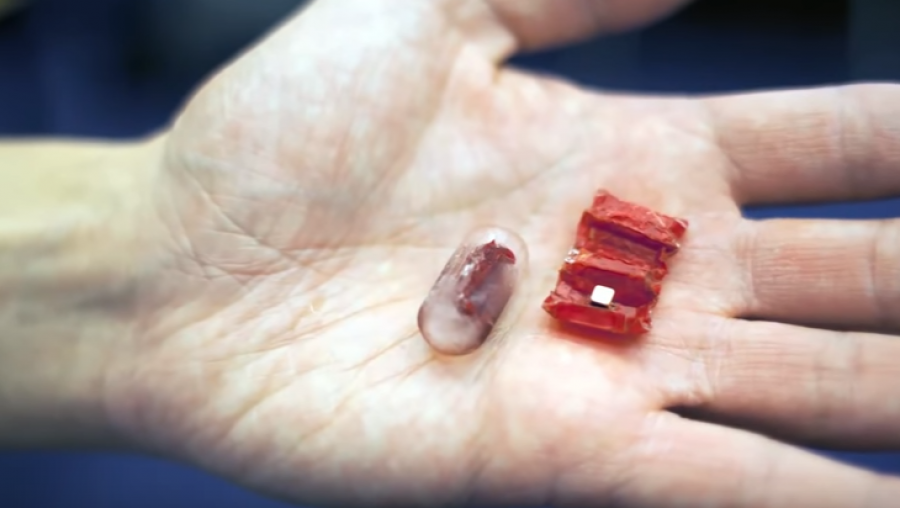

La contrainte n’est pas là, mais dans le transistor ou, si on préfère, dans le mot “puce”. Moore y avait fait allusion en déclarant en 1997 que la croissance des performances des puces se heurterait aux environs de 2017 à une limite physique : celle de la taille des atomes.

Et certains en arrivent à se demander si le transistor à un seul atome est aujourd’hui en avance sur la loi de Moore ? Un groupe international de chercheurs, principalement australiens, vient en effet d’annoncer être en mesure de fabriquer avec précision un transistor composé d’un unique atome de phosphore sur une couche d’atomes de silicium. Ce n’est pas le premier transistor monoatomique mais c’est la première fois qu’on en fabrique un de façon suffisamment contrôlée pour espérer passer un jour à une production industrielle. Dépassant les prédictions de la loi de Moore, la performance pourrait hâter la réalisation d’ordinateurs quantiques vraiment performants.

Comme l’un de ces chercheurs le précise dans cette vidéo, la réalisation contrôlée de transistors monoatomiques est en avance sur la loi de Moore, qui la prévoyait pour 2020. Une technique basée sur l’emploi d’un microscope à effet tunnel aurait permis aux chercheurs des universités de New South Wales, Purdue et Melbourne de vaincre les obstacles rencontrés jusqu’ici par leur collègues explorant le nanomonde.

Ils sont confrontés à une alternative :

- atteindre une limite physique puisque l’on est là dans le domaine où règnent la mécanique quantique, son brouillard probabiliste et les inégalités de Heisenberg ;

- s’intéresser aux ordinateurs quantiques qui deviennent possibles.

Le fait est qu’aujourd’hui, en 2013, le vraisemblablement dernier produit connu, le 62-Core Xeon Phi de Intel, comporte 5000 millions de transistors. Cela explique la juxtaposition à quoi conduit la loi de Moore dans la figure 1.

L’avenir de la monnaie

Cela explique aussi que la technique ne demande qu’à être développée par certains ou appliquée par d’autres pour que croisse davantage encore l’activité économique, en particulier, dans le domaine qu’il est malheureusement classique de dénommer “monnaie”. Ce qu’on dénomme abusivement “monnaie” aujourd’hui est sans relation avec ce qu’on dénommait “monnaie” il y a cent ans et auparavant. Le bouleversement réglementaire gutenbergien qu’ont mis en œuvre les hommes de l’État d’abord dans la décennie 1930, puis en 1971-73, est dérisoire comparé au bouleversement d’innovations numériques en cours aujourd’hui.

Où cela peut-il mener ? L’avenir le dira et seulement lui dont nous sommes les causes !

—

Sur le web.

” Il vise aussi à s’interroger sur l’avenir de la “loi de Moore” qui, en particulier, a contribué à faire passer les gens du monde de l’ère de Gutenberg à celui de l’ère numérique.”

la loi de moor est prédictive, elle n’a contribué a rien, elle constate, c’est tout.

Loi de Moore est surtout un postulat qui valide un business modèle qui a servit de base à toute l’économie numérique, à savoir l’augmentation de la puissance et de la capactité des appareils electroniques (associée a une diminution de leur taille) en même tempos qu’une réduction de leurs coûts de fabrications. Cela conduit à quelques choses du genre, un smartphone coûte 300 dollars aujourd’hui et est aussi puissant et bien plus petit qu’un Cray 1 qui coûtait quelques centaines de millions de dollars et tenait dans une salle de 100m².

Les américains ont envoyé apollo 11 sur la lune avec moins que la puissance d’une calculette “moderne”. Ca pose quand même question sur l’utilité du déluge de puissance actuel.

L’utilité ? Je sais pas, moi, par exemple internet, l’impression 3D, la recherche génétique, la prévision des séismes, les calculs météorologiques, la substitution d’organes défaillants comme les yeux ou l’ouïe, l’optimisation des processus de production, la détection de gisements de matière première, la recherche fondamentale, la domotique, la fabrication de haute précision de petits objets, le cinéma 3D, le Blue-Ray, l’accroissement constant de la sécurité des moyens de transports, l’optimisation des micro financements, la téléphonie mobile, etc. Les applications se compte par millions. Si vous ne les voyez pas, c’est que vous avez choisi de fermer les yeux…

Je n’ai pas le temps de développer. Mais j’ai un long article de vaclav smil sous la main développant largement ce point de vue : Smil, V. 2010. Arguments against the claim that computing has been the most significant innovation of the 20th Century, In The Economist (facilement trouvable via google)

Les tâches que demandaient Apollo 11 sont primitives et n’importe quel microcontrolleur ferait mieux.

Si on codait encore tout en assembleur directement on pourrait faire des programmes encore plus optimisé mais ça prendrais 100 fois le temps (sans exagération). Alors on peut se permettre de gaspiller un peu de mémoire et de temps processeur pour mettre plus de temps à coder des fonctions à plus grande valeur ajoutée.

Bobjack

Si contrôler la combustion et la trajectoire d’une bombe à étages de 3000 tonnes ,décollant à la verticale, pour une trajectoire de 200km, ça ne demande que des “calculs primitifs”, j’aimerais bien savoir ce qui, à vos yeux, mérite l’appellation de “calculs sophistiqués”.

Quoi qu’il en soit, je note que vous admettez l’idée que les progrès sur le hardware sont amputés par le laisser aller dans le codage. Si cette stratégie a pu être valide pour les ordinateurs de bureau, pour qui le facteur limitant est essentiellement la capacité de dissipation thermique, ça ne l’est plus du tout pour les dispositifs mobiles, qui constituent désormais l’essentiel du potentiel de croissance des marchés de l’électronique. Il suffit d’observer les choix d’investissements réalisés par Intel.

Il ne faut pas oublier que les couts de développement, eux aussi, suivent des courbes exponentielles. I.e, si la valeur ajouté ne suit pas aussi une courbe exponentielle, il y aura blocage. Ce que se contentent de dire les “pisse froid”, c’est que la valeur ajouté de la puissance électronique marginale a quitté l’exponentielle depuis un bail. Ca n’est pas un drame, sauf si on est un croyant du progrès technologique, un investisseur peu diversifié, ou un politicien prêt à gober toute promesse de croissance illimité permettant de soutenir son schéma de ponzi; tous tenant la conjecture de moore pour une loi de la nature fléchant la voie vers la prospérité.

Je ne sais pas dans quel domaine vous travaillé mais 99% des production manufacturière actuelle serait soit impossible, soit non rentable si l’informatique n’avait pas progressé comme elle l’a fait. La puissance de calcul c’est un peu comme l’énergie, plus on en a plus cela multiplie les possibilités d’action.

Vivement la fin de la loi de Moore !

Depuis 10 ans, les seules innovations sont commerciales, les ordinateurs sont si bon marché que chacun les préfère à son cerveau. Or ce sont les pénuries et les difficultés qui stimulent l’innovation, l’abondance ne conduit qu’à la dépendance et l’asservissement.

Ce qu’il y a de bien avec l’innovation c’est qu’il n’y a pas de limite. Vous pouvez mettre a genou n’importe quel super computer actuel il suffit de laisser libre court à son imagination. Une modélisation précise du climat de la terre? un simple rendu en ray tracing en temps réel? la simulation de phénomène turbulent? et j’en passe…

@ MichelO

J’imagine qu’à l’apogée de la machine à vapeur et charbon le même raisonnement était tenu, puis survint le la machine à pétrole et combustion interne.

Je ne crois pas qu’on puisse comparer avec la machine à vapeur. Plutôt le papier, le verre, etc. Dans les années 60 à 80, des tas de gens se sont triturés la cervelle parce que l’ordinateur était une ressource rare, ils ont inventé des algorithmes. Quand les lumières se sont mises à clignoter trop vite en face avant pour pouvoir décider si l’algorithme avait convergé, ils ont développé l’analyse de la convergence de ces algorithmes. Mais depuis quelques années, ils n’inventent plus, ils pensent au mieux qu’il suffit d’augmenter la définition des modèles et le volume de données assimilées, au pire qu’il suffit de demander sur internet. C’est la vie, elle est bien plus facile qu’il y a 40 ans, je ne vois que des améliorations cosmétiques depuis 10 ans. Je ne les dénigre pas, mais je ressens un manque, celui du moteur de l’innovation par la volonté de résoudre des problèmes, et une fausse croyance que plus de puissance et de mémoire nous dispense de l’effort intellectuel de le faire. La prise de conscience salvatrice devrait, à mon avis, intervenir quand il deviendra plus coûteux d’augmenter encore la puissance, on se rendra compte alors qu’il y a d’autres innovations susceptibles de résoudre les problèmes.

Je suis du côté des pisse froid vis a vis des progrès de l’électronique. Pour un développement de ce thèse, voir les liens ci dessous :

Smil, V. 2010. Arguments against the claim that computing has been the most significant innovation of the 20th Century, In The Economist:

http://www.vaclavsmil.com/wp-content/uploads/docs/smil-article-economist-20101019.pdf

http://www.vaclavsmil.com/wp-content/uploads/docs/smil-article-economist-20101022.pdf

http://www.vaclavsmil.com/wp-content/uploads/docs/smil-article-economist-20101027.pdf

L’avantage de ce genre de discussion, c’est qu’elle sera tranchée dans les prochaines années par le marché, quelles que soient les manips des États et des pisse-froids.

Pour le moment, tout montre que le progrès technologique a apporté de multiples bienfaits, que les progrès de l’électronique sont phénoménaux et que tout le monde s’en satisfait. Les pisse-froids ragent, écrivent de longs articles et … rien. Le marché s’en fout.

Pour le moment, tout montre que le progrès technologique a apporté de multiples dépendances et asservissements…et que tout le monde s’en satisfait.

La découverte du feu n’est-elle pas un asservissement, si on prend cette logique?

Bien sûr que tout progrès apporte une dépendance, puisque le but même de ce progrès est que l’on s’en serve…

Le feu, oui, c’est un asservissement à la connaissance dispensée par autrui, au détriment de l’astuce individuelle. Taleb dans Antifragile voit ainsi l’opposition entre Prométhée et Epiméthée, entre assistanat et prise de risque, et je suis d’accord avec lui.

Il ne s’agit pas d’être rageur ou interventionniste. Il s’agit de relativiser.

Mais bon, étant singulariste, il est normal que vous défendiez votre chapelle.

On est bien d’accord, le marché tranchera, et pour le moment l’évolution du prix de la puissance et de la mémoire montre, à mon avis, que ça n’intéresse plus grand monde.

Même si je suis en gros d’accord pour dire qu’aujourd’hui, je ne pense pas que le grand public soit en quête de puissance, le fait est que par le passé, une diminution du prix d’un objet à rarement conduit à une diminution de la consommation. C’est généralement l’inverse. Ici, le problème à mon sens vient du fait qu’on ne sait vraiment plus quoi faire de tant de puissance, si ce n’est en profiter pour coder comme des brutes et négliger/économiser (les couts de développement de) l’optimisation des ressources machine.

Si on peut encore appeler ça coder. Au delà de la dépendance et de l’asservissement pointés par MichelO, il y a un bon joyeux je m’en foutisme directement issu de la puissance pléthorique qui condamne les possesseurs d’ordinosaures à changer de machine pour espérer faire fonctionner des obésiciels monstrueusement démesurés en regard de ce qu’ils font réellement.

Le coût du travail est plus important que le fout des machines donc, économiser le travail (coder rapidement) en achetant de la performance matériel pour compenser est valide économiquement.

Cet argument moisi traîne depuis les années 70…

Cela fait 30 ans que le prix de la mémoire et de la puissance s’effondre, personne ne s’est plaint jusqu’à maintenant…

Je ne vois pas pourquoi on s’en plaindrait, mais ça n’est pas non plus, à mon avis, révélateur d’un progrès quelconque.

Quant au coût du travail, quel argument stupide ! Le coût d’un logiciel, c’est celui de sa qualité, de la bonne formation des programmeurs, de l’astuce des algorithmes, de l’intelligence de l’analyse. Le meilleur moyen de le réduire est de réutiliser du code existant, et les plus gros obstacles sont les brevets sur le look and feel, la perte du job du programmeur qui aurait réécrit tout l’existant, et le besoin commercial de faire acheter des systèmes plus puissants en rendant les anciens poussifs ou carrément incompatibles.

Il y a un aspect non négligeable qui n’est pas abordé, c’est celui des énergies utiles au fonctionnement des ordinateurs.

Moins d’électricité pour les alimenter.

Moins de chaleur à évacuer.

+1 hippolyte canasson, DoM P, h16

http://www.youtube.com/watch?v=_UgE-NhcmbM , comment demain sera fait …