Par Christophe Benavent

L’opération HBSC, lancée par Le Monde et quelques dizaines de journalistes, systématise l’institution des lanceurs d’alerte. Elle peut être vue dans une perspective plus large où l’open data, la restitution des données, la « reproductible research » – qui, dans cette note, nous intéresse au premier plan – sont des variétés adaptées à des contextes différents mais procèdent d’une même idée quant à la manière d’assurer que les institutions rendent des comptes : c’est la notion d’accountability, dont il faut utiliser la (re)traduction française de “redevabilité” et que l’on justifie autant par la responsabilité que par la réduction des asymétries d’information.

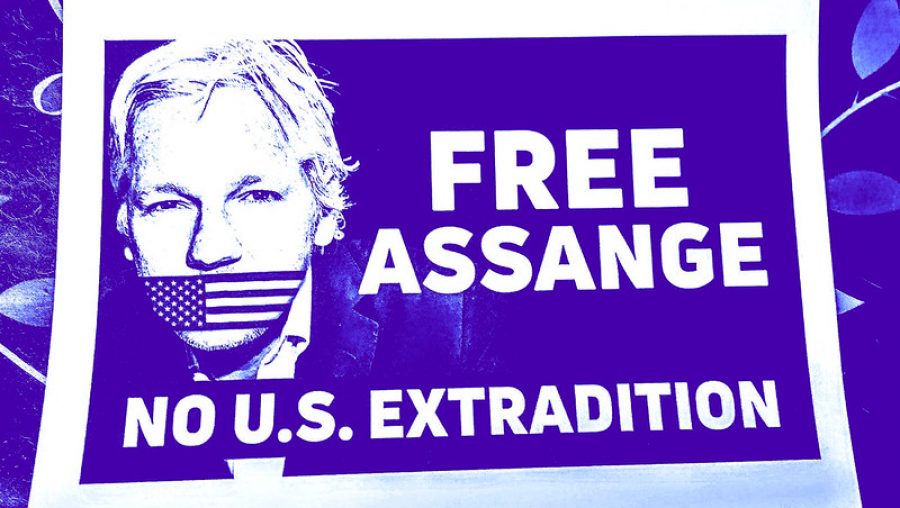

C’est bien l’idée de l’open data : l’obligation qui s’impose aux États et aux collectivités de publier les statistiques qu’ils produisent, afin de faciliter la contrôlabilité des politiques publiques par la nation et ses représentations dans l’espoir d’accroitre la participation démocratique. C’est aussi l’idée de restitution des données, dont l’idéal serait que chaque entreprise partage l’intégralité des données collectées sur chaque individu avec chacun d’eux. De cette manière, les entreprises pourraient ainsi rendre compte de ce qu’elles font des informations qu’on leur a donné. Dans le cas des leaks, il s’agit au fond de la même choses : en exploitant intensément des masses de données, les journalistes jouent un rôle essentiel dans un univers économique où, au prétexte de la confidentialité des affaires, un monde très obscur peut s’édifier. Bien sûr dans ce dernier cas, les données ont été, disons, empruntées – puisque de droit les données ne sont pas des propriétés et ne peuvent pas être volées. Dans tous les cas, la transparence des données est ainsi au cœur du contrôle de nos institutions.

Il en est de même pour la notion de recherche reproductible qui se développe à grands pas depuis quelques années. Le monde de la science n’est pas plus pur que les autres. Certains se trompent comme on l’avait découvert avec l’affaire Reinhart et Rogoff dont les calculs se sont avéré erronés, alors que leur article affirmait que la dette ne peut dépasser les 90% du PIB. D’autres trichent comme Diederik Stapel. Un nouvel impératif s’impose : pour que les reviewers puissent mieux vérifier les calculs, et tant qu’à faire, quiconque dans la communauté, il est nécessaire que le code de l’analyse et les données soient accessibles aux tiers et notamment des évaluateurs de revues.

À ce mouvement général s’accordent des outils spécifiques (Sources Sure pour les leaks, OpenDatasoft pour l’open data, pour ne donner que deux exemples). Pour la « reproducible research », r est parfaitement adapté à la tâche avec plusieurs de ses packages : Sweaver ou knitr. Il viendra bientôt un temps où l’on partagera sur Github ou une autre plateforme ses données et son code à fin de vérification. C’est une toute autre manière de travailler qui s’impose et impose son langage. La notion même de résultat qui se concrétisait dans des tableaux de résultats plus ou moins standardisés et la production de graphiques évoluent vers la mise à disposition des données et du code qui permet de les analyser. Dans les disciplines de la gestion, cette question commence à peine à être posée, il est probable qu’assez rapidement elle devienne un standard. Pour s’y préparer, il va falloir en apprendre les techniques.

—

Sur le web.

Je suis pour que vos conversations privées avec votre psy soient accessibles sur le net… Ce n’est bien sûr pas du vol… juste une emprunt…

J’ai toujours été en faveur d’une politique open data. Mais j’ai compris à mes dépends que ce n’était pas toujours aussi facile. Quand il m’arrive de demander des données originales, il n’est pas rare qu’on me refuse, et la raison communément invoquée serait qu’ils n’ont pas le droit. L’institution ou l’entreprise leur ayant formellement interdit de partager quoi que ce soit. On m’avait dit alors qu’il fallait que je fasse des démarches administratives, mais que c’est tellement dans le domaine de l’impossible qu’on m’a souvent recommandé d’abandonner.

Parfois, la faute n’est pas celle des chercheurs eux-mêmes.

Néanmoins, il y a des fois où ils exagèrent. Je me souviens avoir demandé, il y a quelques mois, des chiffres sur un certain test QI, le Woodcock-Johnson III, à un groupe de chercheurs en psychologie. Juste les chiffres des corrélations entre sous-tests du W-J III. Je n’ai jamais demandé les données originales. Juste quelques chiffres de rien du tout. Et pourtant, on m’avait dit que je devais demander une autorisation officielle auprès de la société (ou je ne sais plus quoi). Même pour ça ? Ridicule.