Article disponible en podcast ici.

L’innovation ne peut guère être planifiée, encore moins par un État. Par exemple, une simple amélioration sur les radios a permis l’essor de toute l’électronique et de l’informatique.

Le long parcours du transistor

L’étude de l’électricité a rangé les matériaux selon leur résistance au courant. Ceux qui ont une résistance basse sont des conducteurs comme le cuivre, ils laissent passer l’électricité. Ceux qui ont une résistance élevée seront des isolants, comme le caoutchouc.

Cependant, on remarque que dans certains cas cette résistance est pilotable.

En 1833, Faraday s’est rendu compte que la résistance d’un métal décroît avec la température. Edwin Hall découvrit l’effet Hall en 1879 : la résistance d’un métal change en fonction du champ magnétique.

En 1904, John Ambrose Fleming invente le premier tube à vide. Cet appareil permet d’amplifier un courant. Autrement dit, un courant de puissance faible peut faire varier la résistance d’un composant dans lequel circule un courant fort.

La possibilité qu’un faible courant pilote un plus gros courant est la clé de voûte de la radio-télécommunication. Une radio capte un signal électromagnétique dans l’air et doit l’amplifier pour l’utiliser dans un haut-parleur. Le tube à vide est l’élément clé entre l’antenne et le haut-parleur de la radio.

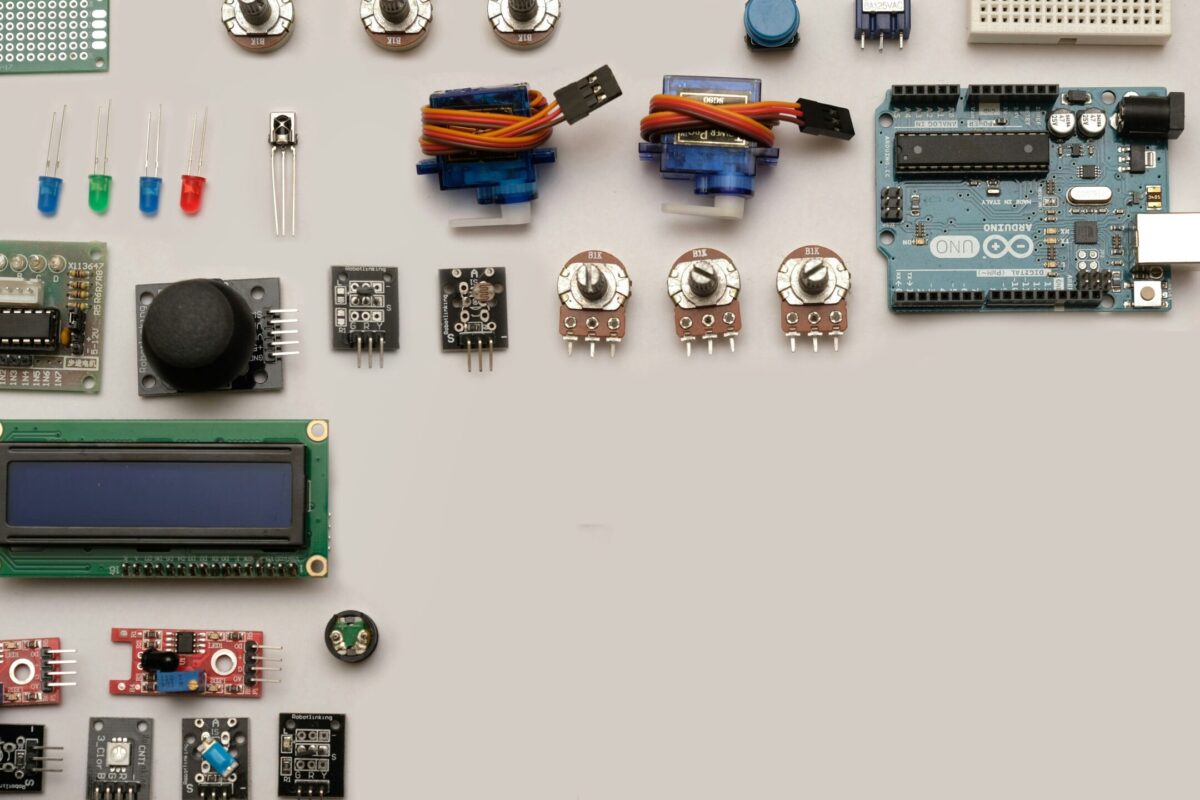

En 1947, des chercheurs américains découvrent les propriétés semi-conductrices du silicium pour fabriquer le premier transistor. Un transistor est un amplificateur de courant comme le tube à vide, mais plus simple, plus fiable, plus petit, et moins coûteux. Il remplaça le tube à vide dans les radios et radars.

La force vient du nombre

Le transistor de 1947 ne mesure que quelques millimètres, et ses transitions d’états sont presque instantanées. Aussi une propriété mathématique devient intéressante.

Un transistor reçoit la puissance à piloter sur une entrée (A), le signal pilote sur l’entrée (B) et le signal amplifié sur la sortie (C). Dans une logique binaire, avec des entrées soient ouvertes soient fermées, il faut que A et B soient ouverts pour ouvrir C. Le transistor peut donc aussi être vu comme un opérateur mathématique élémentaire que l’on nomme AND. Une variante du transistor existe aussi en opposé qu’on nomme NAND (not-AND).

Il a été prouvé qu’avec suffisamment d’opérateurs NAND intégrés les uns aux autres, il est possible de concevoir un circuit réalisant n’importe quelle fonction logique.

On peut donc concevoir des mémoires, des additions, des multiplications et autres à partir de NAND. Or justement en 1958, le premier circuit intégré est produit. Il s’agit d’un processus industriel permettant de concevoir de minuscules transistors directement sur une plaque de silicium.

On peut facilement chaîner des milliers de NAND sur quelques centimètres, et ainsi réaliser n’importe quelle fonction logique.

Toujours plus de transistors

On peut concevoir n’importe quelle fonction logique à condition de chaîner suffisamment de transistors NAND. Un premier phénomène d’émergence est présent avec quelques centaines pour faire des calculatrices. Ou plus généralement un calcul précis.

En passant vers le millier de transistors, on arrive à concevoir des fonctions logiques programmables. Un même circuit intégré peut maintenant avoir plusieurs usages, en fonction de comment on le programme.

En 1971, Intel sort le Intel 4004, le premier microcontrôler programmable avec 2300 transistors. Aujourd’hui, il y a 65 milliards de transistors dans le processeur Apple M2.

Cette évolution spectaculaire du nombre de transistors a corroboré la prédiction du président d’Intel Gordon Moore qui envisageait un doublement du nombre de transistors dans les ordinateurs tous les six mois. Cette explosion a ouvert la voie à l’informatique. Cette fonction logique présente dans nos processeurs permet maintenant de programmer n’importe quel cas d’usage.

L’informatique a été possible, car un élément fort simple comme un opérateur NAND a pu être fabriqué et assemblé par milliers, puis millions et maintenant milliards sur une plaque de silicium de quelques centimètres.

Par sa multitude, l’opérateur NAND peut devenir n’importe quelle fonction logique, y compris des fonctions logiques programmables pour faire fonctionner nos ordinateurs et nos smartphones.

Le rôle du transistor aujourd’hui se retrouve très éloigné du simple remplacement du tube à vide dans les radios.

Dans l’absence de planification, il y a plus remarquable : le pur hasard. Ou la sérendipité.

L’exemple le plus erratique et le plus célèbre est celui de ce produit découvert par un chimiste et dont il sera fait, par un autre, dans un cadre religieux, un usage inattendu : la colle du post-it.

Qui a, en outre, fini par être numérisé par son inventeur (3M) : post-it notes.

Merci pour cet article qui me replonge bien des années en arrière, lorsque je suivais une formation en informatique industrielle au Greta de Vierzon.

J’espère que le président Macron le lira, lui qui assumait nous fixer des objectifs ambitieux, en matière de transition écologique, pour nous obliger à innover plus rapidement.

« »En 1833, Faraday s’est rendu compte que la résistance d’un métal décroît avec la température » »

c’est dans la majorité des cas l’inverse : pour la majorité des métaux la résistance R augmente avec la température (coefficient thermique positif) et dans certains cas très fortement comme par exemple le filament d’une lampe à incandescence qui peux varier d’un facteur 10 entre éteinte et allumée, dans le cas contraire la résistance tendrait vers 0 et l’énergie absorbée serait inversement proportionnelle donc technologiquement pas viable.

Quelques dérogations à la règle, le constantan pour lequel la température n’a pas d’influence, le carbone pour lequel effectivement la résistance chute en fonction de la température ce qui est le cas des isolants en général ..mais les isolants ne sont pas des métaux, certaines thermistances (mesure de la T°) ont aussi un coefficient thermique négatif

Corrigeons une erreur (sans doute involontaire) :

« En 1833, Faraday s’est rendu compte que la résistance d’un métal décroît avec la température »

non, c’est bien entendu l’inverse, la résistance croit avec la température. Sinon, par exemple, nous n’aurions pas pu nous éclairer avec nos ampoules à filament, avant d’être sauvé par la découverte des Led.

La phrase complète est « 1833 : Michael Faraday remarque l’augmentation du pouvoir conducteur de certains métaux lorsque l’on augmente la température, contrairement aux métaux classiques dont la résistivité augmente avec la température. »

Ceux qui prétendent « planifier l’innovation » ont la peur d’être en retard, alors ils convoquent de savants comités d’experts bavards pour tenter de se raccrocher à la mode naissante, définir les « thèmes prioritaires » sur lesquels il faut investir toutes les billes extorquées aux contribuables, expulser des labos les électrons libres qui se passionneraient pour autre chose, construire une pharaonique bureaucratie pour répartir la manne en la gaspillant allègrement jusqu’à constater qu’ils ont suivi une fausse piste tandis que de lointains marginaux auront trouvé une solution simple, économique et efficace.

Modèle du genre, la saga ITER passée et future.

l’innovation peut être « planifiée »…au point d’etre d’ailleurs rendue impossible..

la question nest pas celle ci, c’est la sempiternelle approche erronnée du libéralisme…

le libéralisme n’ets pas un constructiviste progressiste et scientifique.. comme le communisme prétendit l’etre ..

c’est ‘je fais ce que je veux dans les limites du crime..défini par l’atteinte aux liberté individuelles..

et donc j’innove si je veux.

mais j »ai le droit aussi de vouloir rester « pauvres et ignorant..

et le sujet est plutôt la science publique..

la recherche publique repose en partie sur la planification… » je vous promets un retour technologique et économique »..et pour l’autre sur une prétention vertueuse..qui peut la rendre contre productive..

Il faut nuancer. La science fondamentale n’est pas planifiable. Encore que certaines ruptures surgissent quand elles sont dans l’air du temps, ce qu’un planificateur compétent devrait voir.

En revanche la R&D est parfaitement planifiable. Le projet Manhattan en était un exemple.

Ce qui ne marche jamais c’est la planification bureaucratique des pays refusant le libéralisme. Quand les planificateurs sont des bureaucrates incompétents ayant obtenu leur poste par carriérisme et soumission politique, il faut s’attendre au pire (le plan est réalisé sur le papier mais pas en réalité ! et quand il l’est c’est au détriment de pistes bien plus intéressantes).

Il y a par ailleurs une bonne et une mauvaise approche des projets. La bonne, quand on cherche une vraie rupture, est de lancer de nombreux projets (type DARPA) en sachant que très peu arriveront au bout et que l’on n’hésitera pas à laisser tomber les mauvaises pistes. La mauvaise, qui est celle des bureaucrates, est de s’accrocher un projet unique (asséchant tous les autres) sans le remettre en cause jusqu’à l’échec final. Et comme les bureaucrates à l’œuvre sur ce projet ne veulent pas en être dépossédés, ils préfèrent enjoliver les résultats intermédiaires pour qu’il ne s’arrête pas trop tôt et pour garder leur fromage !

L’informatique est un des bons exemples pour parler de la projection scientifique. Depuis la découverte du transistor, la loi de Moore a été longtemps rappelée et, de fait, il suffisait de réduire « tous les deux ans » le volume des composants électroniques. Mais il ne faut pas se leurrer car on peut se douter que nous sommes loin d’une nouvelle découverte. En réalité, dans une certaine mesure, l’informatique n’a guère évolué par elle-même et n’a bénéficié depuis les années 70 que de la miniaturisation des composants et de l’abaissement des coûts de fabrication, et de là, sa popularisation inéluctable à tous les niveaux de la société. Sans parler de la médiocrité stable du logiciel actuel, je ne trouve donc pas d’avancées techniques majeures puisque cette numérisation à grande échelle a déjà fait le reste. De ce point de vue, on peut seulement prévoir des objectifs qui concerneront la production et la consommation puisque la numérisation est dépendante de notre imagination et de nos besoins.

Comme souvent, ce qui freine la traduction pratique d’une percée scientifique est la question des matériaux et de procédés efficaces pour les produire.

Il a fallu presque 50 ans pour arriver au premier transistor à partir des premières théories sur les bandes de conduction dans les semiconducteurs.

Mais quand les verrous matériaux ont été levés, les développements sont devenus très rapides et, au moins au début assez largement planifiés. L’assemblage de nombreux transistors pour faire un processeur est assez lié aux programmes spatiaux américains (civils et militaires). La planification n’est donc pas toujours un échec. Mais il faut des planificateurs d’une autre trempe que nos bureaucrates sans grande culture technique et allergiques au risque.

Les commentaires sont fermés.